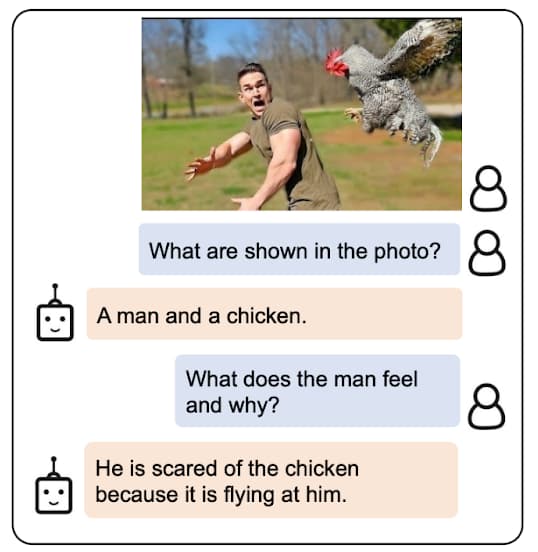

BLIP-2:连接图像与大语言模型的桥梁

为大语言模型LLM开启图像模态输入

很明显,GPT-4的发布在行业内外都引起了轩然大波。BLIP-2的作者显然也注意到了这一点。他们在官网发表了文章详细介绍了BLIP 2与GPT 4的差异:

BLIP-2: Scalable Multimodal Pre-training Method

BLIP-2: Scalable Pre-training of Multimodal Foundation Models for the World’s First Open-source Multimodal Chatbot

BLIP 2作者将差异概括为以下四点:

- 通用还是专用。BLIP 2是一项多模态视觉语言预训练技术,可以为任何大语言模型提供零样本图像到文本生成能力。GPT 4本身就是一种类型,技术原理不明。

- 开源还是闭源。BLIP 2开源。GPT 4闭源。

- 快还是慢。BLIP 2一张图像需要大约1秒。GPT 4要更久。

- BLIP 2采用无监督学习。GPT-4(可能)采用了监督学习。

将11B-LLM转换为多模态基础模型,只需要训练不到2%的参数就可以。之后给定一张图像,可以使用语言交互的方式获取与其相关的内容。