Guanaco的秘密QLoRA

Guannaco说低精度也能获得好效果

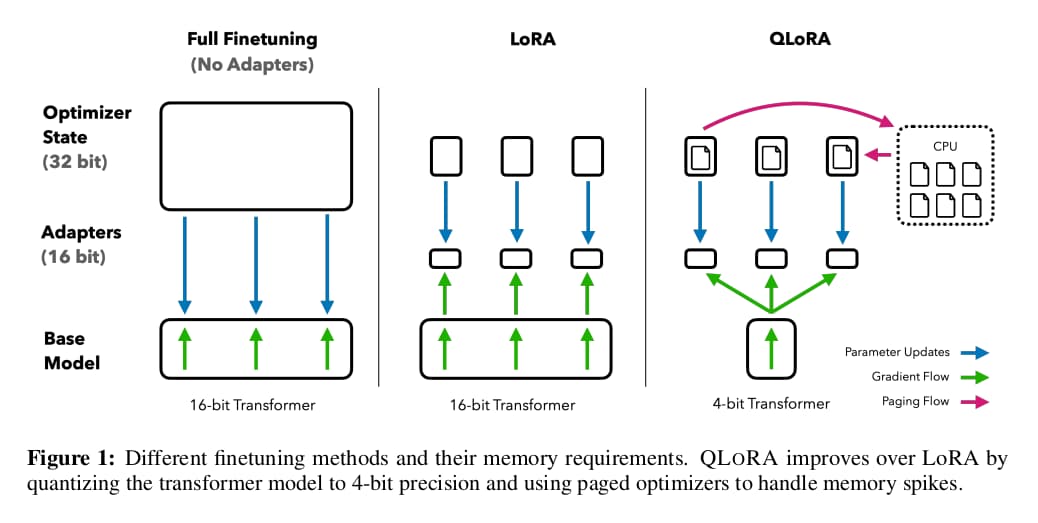

QLoRA是华盛顿大学提出的一种大语言模型的精调方法。它可以在单个48GB显存的GPU上实现65B规模量化模型的精调,而质量与16-bit精调相当。

GitHub - artidoro/qlora: QLoRA: Efficient Finetuning of Quantized LLMs

QLoRA: Efficient Finetuning of Quantized LLMs. Contribute to artidoro/qlora development by creating an account on GitHub.

QLoRA将4-bit量化后的大语言模型与LoRA结合起来,基于LLaMA训练出一系列模型并命名为Guanaco,原驼,一种南美洲的动物。作者声称原驼可以达到ChatGPT 99.3%的水准。

作者将原驼的创新概括为3点:4-bit NormFloat量化格式、双重量化以及Paged Opitimizer内存优化。